ПРОБЛЕМА НОВІТНІХ ТЕХНОЛОГІЙ: ДО УНІВЕРСИТЕТІВ ПРИХОДЯТЬ ДІПФЕЙКИ

На сайті Times Higher Education опублікована стаття Джаспер Роу та Майк Перкінс «На здобуття вищої освіти приходять діпфейки.

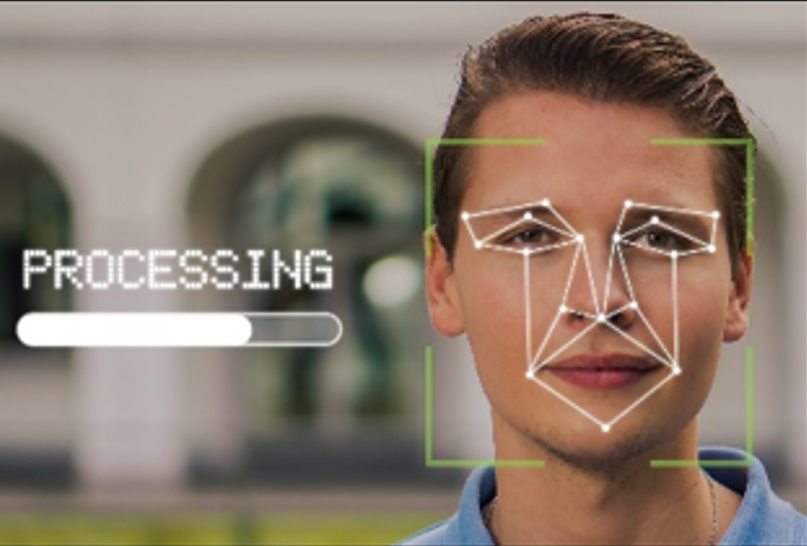

Що ми можемо зробити, щоб підготуватися?». У ній зазначається, що створювати дипфейки наразі стало настільки легко, що студенти та викладачі стають як ніколи вразливими до кіберзлочинів, які шкодять репутації та академічній доброчесності. Технологічний гігант штучного інтелекту OpenAI нещодавно випустив голосовий інструмент, який підозріло нагадує акторку Скарлетт Йоханссон, а відбулось це після того, як вона відмовилася надати голос для тренування ШІ. З’ясувалось невдовзі, що це був не дипфейк, а голос спеціально найнятого актора. Але розгорнулась дискусія щодо того, як зображення та голоси можуть бути відтворені без нашого відома й відповідного дозволу. Існують відмінності між дипфейками та синтетичними носіями. Коли говоримо про синтетичні медіа, маємо на увазі зображення, аудіо чи відео, які не стосуються конкретної людини або установи, а цілком створені ШІ. Дипфейки є підробкою, не маючи насправді відношення до певної особи, але які складно відрізнити від справжніх. Вони створюються завдяки технології Generative Adversarial Networks (GAN) для імітації голосу та міміки. Ця технологія стрімко розвивається: Microsoft нещодавно продемонструвала програму під назвою VASA-1 , яка може створити розмовну голову з одного зображення та короткого голосового фрагменту, доповненого природними рухами голови та мімікою. Невдовзі інші технологічні компанії надолужать відставання і масово з’являться у широкому доступі програми, які швидко й просто створюють менш складні дипфейки. Для навчальних закладів це створюватиме ризики. Педагоги виконують вирішальну роль у навчанні студентів, захистом академічної доброчесності та репутації ЗВО. Дипфеки можуть змарнувати усі ці зусилля. Автори статті у зв’язку з цим пропонують оновити політику університетів по відношенню до кіберзлочинів; підвищити обізнаність усіх учасників освітнього процесу щодо дипфейків; розробити плани врегулювання кризових ситуацій подібного роду (які включатимуть підтримку постійної комунікації у кризових ситуаціях, спілкування із зацікавленими сторонами та засоби відновлення довіри). Разом із тим, технологія дипфеку може мати потенційну користь, якщо використовуватиметься для створення ефекту занурення в навчання, моделюванні розмов із провідними історичними діячами, створення переконливих лекцій з нотаток і фотографій. Баланс між інноваціями та пильністю буде ключем до того, щоб переваги штучного інтелекту та синтетичних медіа покращували, а не підривали освітній досвід.

Детальніше: http://surl.li/zbeyqf, http://surl.li/fonkxc, http://surl.li/mjsjla

Фото: pixabay.com

#НРАТ_Усі_новини #НРАТ_ШтучнийІнтелект #НРАТ_Освітянам_новини #НРАТ_АкадемДоброчесність